par Christopher Michael Langan, © 2002

Abstract : Dans la mesure où la science est observationnelle ou perceptuelle par nature, l’objectif de fournir un modèle et un mécanisme scientifiques pour l’évolution de systèmes complexes nécessite ultimement une théorie de la réalité qui la supporte, dont la perception elle-même est le modèle (ou cartographie théorie-à-univers). Lorsque l’information est la monnaie d’échange abstraite de la perception, une telle théorie doit incorporer la théorie de l’information tout en élargissant le concept d’information à un auto-traitement réflexif afin de parvenir à une description intrinsèque (autonome) de la réalité. Cette extension est associée à une formulation limitative de la théorie des modèles identifiant la réalité mentale et physique, aboutissant à une théorie de la réalité auto-génératrice réflexive, auto-modélisante, identique à son univers au niveau syntactique. Par la nature même de sa dérivation, cette théorie, le Modèle Théorique-Cognitif de l’Univers ou CTMU, peut être considérée comme une extension réalité-théorique supertautologique de la logique. Unissant la théorie de la réalité à une forme avancée de la théorie du langage informatique, le CTMU décrit la réalité comme un langage Auto-Configurant Auto-Traitant ou SCSPL, un langage intrinsèque réflexif caractérisé non seulement par l’autoréférence et l’autodéfinition récursive, mais aussi par la pleine auto-configuration et l’auto-exécution (fonctionnalité de lecture-écriture réflexive). La réalité SCSPL incarne un monisme à double aspect consistant en une infocognition, une information auto-transductrice résidant dans des éléments auto-reconnaissants SCSPL appelés opérateurs syntactiques. Le CTMU s’identifie lui-même à la structure de ces opérateurs et donc à la syntaxe distributive de son univers SCSPL auto-modélisant, y compris la grammaire réflexive selon laquelle l’univers s’affine à partir de la télèse non bornée ou UBT, un domaine primordial de potentiel infocognitif libre de contrainte informationnelle. Sous la direction d’un principe anthropique limitant (intrinsèque) appelé Principe Télique, le SCSPL évolue par récursion télique, configurant conjointement la syntaxe et l’état tout en maximisant un paramètre d’auto-sélection généralisé et en s’ajustant à la volée à des conditions internes librement variables. Le SCSPL relie l’espace, le temps et l’objet aux moyens de dualité conspansive et de conspansion, un processus grammatical-SCSPL présentant une alternance entre deux phases d’existence associées à la conception et à l’actualisation et liées à la dualité onde-particule familière de la mécanique quantique. En distribuant la phase de conception de la réalité sur la phase d’actualisation, l’espace-temps conspansif fournit également un mécanisme distribué pour la Conception Intelligente, contigu au principe restrictif de la sélection naturelle, un moyen basic de génération d’information et de complexité. Abordant l’évolution physique non seulement au niveau biologique mais aussi au niveau cosmique, le CTMU s’attaque aux carences et aux paradoxes les plus évidents associés aux modèles de réalité discrets et continus classiques, y compris la directionnalité temporelle et l’accélération de l’expansion cosmique, tout en préservant pratiquement tous les avantages majeurs des paradigmes mathématiques et scientifiques actuels.

Introduction

Parmi les développements scientifiques récents les plus intéressants il y a, la Théorie de la Complexité, la théorie des systèmes auto-organisants, et l’incarnation moderne de la Théorie de la Conception Intelligente, qui étudie la profonde relation entre l’auto-organisation et la biologie évolutionnaire dans un contexte scientifique non préventivement fermé à la causalité téléologique. Contre le réductionnisme physique traditionnel des sciences dures, la théorie de la complexité a donné naissance à une nouvelle tendance, le réductionnisme informationnel, selon laquelle le fondement de la réalité n’est pas matière et énergie, mais information. Malheureusement, cette nouvelle forme de réductionnisme est aussi problématique que l’ancienne. Comme l’écrit le mathématicien David Berlinski à propos des aspects matériels et informationnels de l’ADN : « Nous savons ce qu’est l’ADN: c’est une macromolécule et donc un objet matériel. Nous savons très bien ce que cela donne: apparemment tout. Les deux côtés de cette équation sont-ils en équilibre ? ». Plus généralement, Berlinski fait remarquer que, puisque l’information contenue dans une chaîne d’ADN ou de protéine ne peut affecter la dynamique matérielle de la réalité sans être lue par un transducteur matériel, l’information n’a pas de sens sans matière.1

La relation entre réductionnisme physique et informationnel est révélatrice, car elle reflète directement le dualisme esprit-matière Cartésien, source de plusieurs siècles de controverses philosophiques et scientifiques sur la nature de la réalité profonde.2 Tant que la matière et l’information restent séparées, les spécialistes considérant l’un comme primaire et reléguant tacitement l’autre au statut secondaire, le dualisme reste en vigueur. Dans cette mesure, l’histoire ne fait que se répéter; là où l’esprit et la matière se disputaient autrefois le statut principal, la matière concrète rivalise maintenant avec des informations abstraites représentant de manière abstraite la matière et ses relations étendues. Mais tandis que l’abstraction formelle et la descriptivité de l’information semblent donner un compromis louable entre esprit et matière, le commentaire de Berlinski montre son insuffisance en tant que substitut conceptuel. Ce qui est maintenant requis est ce qui l’a été tout du long : un cadre conceptuel dans lequel la relation entre l’esprit et la matière, la cognition et l’information, est explicitée. Ce cadre doit non seulement permettre d’achever la dissolution constante progressive du diviseur cartésien esprit-matière, mais également de construire un pont logique praticable au-dessus du fossé explicatif résultant.

Mathématiquement, le cadre théorique de la Conception Intelligente se compose de certains principes définitifs régissant l’application de la complexité et de la probabilité à l’analyse de deux attributs essentiels des phénomènes évolutionnaires, la complexité irréductible3 et la complexité spécifiée4. D’une part, étant donné que les mathématiques de probabilité doivent être interprétées causalement pour avoir une signification scientifique et que les probabilités sont donc expressément relativisées par rapport à des scénarios de causalité spécifiques, il est difficile d’attribuer des probabilités définies à des états évolutionnaires dans un modèle ne prenant pas en charge la reconstruction et l’analyse détaillées des voies causales spécifiques. D’autre part, poser « l’improbabilité absolue » d’un état évolutionnaire implique ultimement la spécification d’un modèle absolu (global intrinsèque) par rapport auquel il est possible de déterminer des écarts probabilistes absolus. Quelques réflexions suffisent pour nous informer de certaines de ses propriétés : il doit pouvoir être déduit rationnellement de principes a priori et essentiellement tautologiques par nature, il doit en quelque sorte identifier matière et information, et doit éliminer le fossé explicatif entre les aspects mentaux et physiques de la réalité. En outre, conformément au nom de ce qui doit être modélisé, il doit intégrer de manière significative les concepts d’intelligence et de conception, décrivant l’univers comme un système intelligemment auto-conçu et auto-organisé.

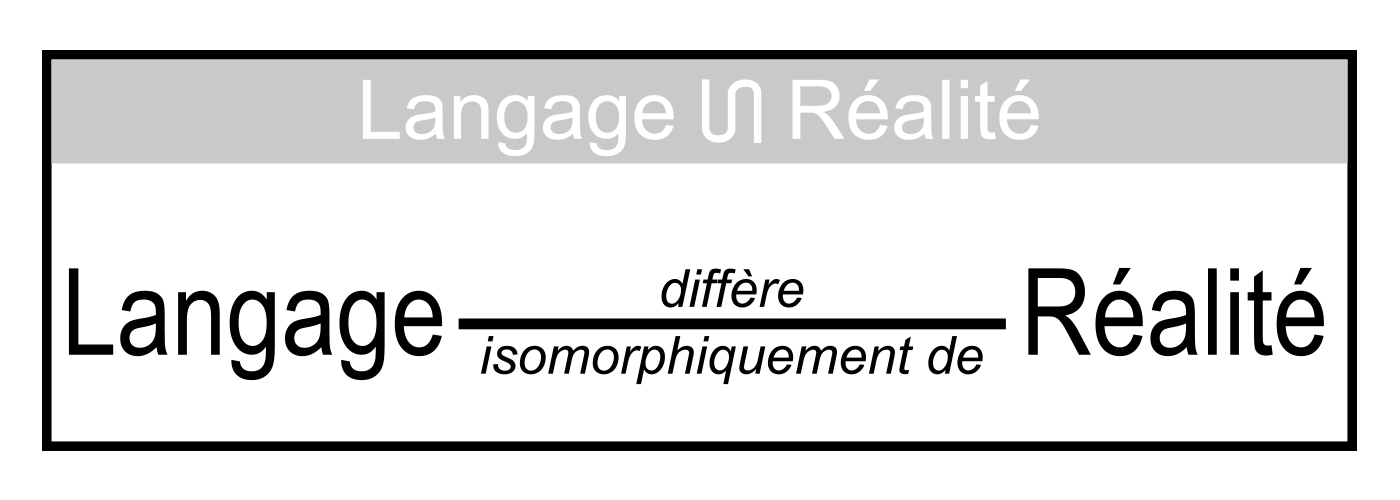

Comment est-ce fait ? En un mot, avec le langage. Cela ne signifie pas simplement que le langage devrait être utilisé comme un outil pour analyser la réalité, car cela a déjà été fait d’innombrables fois avec des degrés variés de succès. Cela ne signifie pas non plus que la réalité devrait être considérée comme un langage machine fonctionnant dans une sorte de vaste ordinateur. Cela signifie, utiliser la langue comme un paradigme mathématique en soi. De toutes les structures mathématiques, le langage est la plus générale, la plus puissante et la plus nécessaire. Non seulement chaque théorie formelle ou fonctionnelle de science et des mathématiques est par définition une langue, mais la science et les mathématiques, dans leur ensemble et leur somme, sont des langages. Tout ce qui peut être décrit ou conçu, y compris toute structure, processus ou loi, est isomorphe à une description ou définition et est donc qualifiable en tant que langage, et chaque créature sensible affirme constamment la structure linguistique de la nature en exploitant l’isomorphisme syntactique pour percevoir, conceptualiser et se référer à elle. Même la cognition et la perception sont des langages basés sur ce que Kant aurait pu appeler « syntaxe phénoménale ». Avec la logique et les mathématiques parmi ses ingrédients syntactiques les plus fondamentaux, le langage définit la structure même de l’information. C’est plus qu’une vérité empirique; c’est une nécessité rationnelle et scientifique.

Le fait que les lois de la nature soient un langage est particulièrement intéressant pour les scientifiques des sciences naturelles. Dans une certaine mesure, la nature est régulière; les modèles de base ou les aspects généraux de la structure en fonction desquels elle est appréhendée, qu’ils aient été identifiés de manière catégorique ou non, sont ses « lois ». L’existence de ces lois est donnée par la stabilité de la perception. Parce que ces modèles répétitifs ou lois universelles décrivent simultanément plusieurs instances ou états de la nature, ils peuvent être considérés comme des « instructions » distribuées à partir desquelles les auto-instanciations de la nature ne peuvent pas dévier; ainsi, ils forment un « langage de contrôle » à travers lequel la nature régule ses auto-instanciations. Ce langage de contrôle n’est pas du type habituel, car il est en quelque sorte intégré au tissu même de la réalité et semble outrepasser les limites connues des systèmes formels. De plus, il est profondément réflexif et autonome en ce qui concerne les opérations de configuration, d’exécution et de lecture-écriture. Seuls quelques-uns des audacieux ont été disposés à réfléchir à la manière dont cela pourrait fonctionner… à demander où les lois pourraient en réalité résider, comment elles pourraient être exprimées et mises en œuvre, pourquoi et comment elles sont apparues et comment leur consistance et leur universalité sont maintenues. Bien que ces questions présentent clairement un grand intérêt scientifique, la science seule est logiquement insuffisante pour y répondre; un nouveau cadre explicatif est nécessaire. Cet article décrit ce que l’auteur considère comme le cadre le plus prometteur dans les termes les plus simples et les plus directs possibles.

Sur une note d’indulgence, il a toujours été réconfortant de croire que les méthodes empiriques-mathématiques classiques hybrides de la physique et de la cosmologie suffiront à révéler le véritable cœur de la nature. Cependant, de nombreux signaux indiquent qu’il est peut-être temps de tenter une nouvelle approche. Avec les vrais croyants ne se laissant pas intimider par les limitations explicatives (mathématiquement factuelles) des anciennes méthodes, nous devons bien sûr faire preuve d’empathie; il est difficile de remettre en question ses investissements antérieurs quand on a déjà investi toute la foi que l’on a. Mais la science et la philosophie ne progressent pas en considérant leurs investissements passés comme une fin en soi; l’objet est toujours de préserver ce qui a de la valeur dans les méthodes anciennes tout en joignant de nouvelles méthodes qui affinent leur signification et élargissent leurs horizons. La nouvelle approche que nous allons explorer dans cet article, qui pourrait être décrite de façon pittoresque comme « la théorie de la réalité est liée à la théorie du langage et elles engendrent une synthèse », présente l’avantage de laisser virtuellement intact l’image actuelle de la réalité. Elle crée simplement une image miroir logique de l’image actuelle (son double conspansif), fusionne les moitiés symétriques de l’image résultante et tente d’extraire des implications significatives. La science telle que nous la connaissons est ainsi peu modifiée en contrepartie de ce qui peut, si le destin nous sourit, se révéler être de vastes gains en profondeur, en signification et en pouvoir explicatif.

Et sur cette note, je vous remercie de votre aimable attention et vous souhaite un voyage fructueux.

Théories, modèles et fausses dichotomies

Il est presque devenu embarrassant de faire remarquer que la science est en état de crise… non pas parce que c’est erroné, mais parce c’est devenu un cliché trop souvent accompagné de peu ou pas d’éclaircissement correcteur. Malgré toutes les réalisations magnifiques de la science, ses ambitions grandioses ont réussi depuis longtemps à éprouver ses modèles traditionnels et ses principes d’organisation au-delà de leurs limites explicatives. À la recherche d’explications toujours plus profondes et plus larges, la science a atteint le point où elle ne peut plus nier l’existence de difficultés conceptuelles insolubles conduisant aux insuffisances explicatives de ses modèles conceptuels fondamentaux de la réalité. Cela a engendré une nouvelle discipline connue sous le nom de théorie de la réalité, l’étude de la nature de la réalité dans son sens le plus large. L’objectif général de la théorie de la réalité est de fournir de nouveaux modèles et de nouveaux paradigmes aux termes desquels la réalité peut être comprise, et la consistance de la science être restaurée à mesure qu’elle s’approfondit et élargit son étendue.

La théorie de la réalité dominante compte parmi ses foyers les plus chauds l’interprétation de la théorie quantique et sa réconciliation avec la physique classique, l’étude de la conscience subjective et ses relations avec la réalité matérielle objective, la réconciliation entre science et mathématiques, la théorie de la complexité, la cosmologie et les branches connexes de science, mathématiques, philosophie et théologie. Mais dans un sens intégrée, elle est actuellement dans un mode exploratoire, occupée à la recherche d’un cadre conceptuel général dans lequel développer une théorie et un modèle de réalité plus spécifiques, capables de résoudre les paradoxes et les inconsistances conceptuelles qui affectent ses différents domaines d’intérêt (où un modèle est techniquement défini comme une interprétation valide d’une théorie dans son univers de référence). En raison de la portée universelle de la théorie de la réalité, elle est sujette à des exigences uniques et rarement reconnues; par exemple, puisqu’il s’agit par définition d’une théorie universelle de tout ce qui est réel, elle doit par définition contenir ses règles d’interprétation du monde réel. C’est-à-dire que la théorie de la réalité doit contenir son propre modèle et lui affecter sa propre cartographie auto-interprétative, et elle doit se conformer aux implications de cette exigence. Cette capacité « d’auto-modélisation » est un critère principal du cadre requis.

Les rangs des théoriciens de la réalité incluent des chercheurs de presque toutes les disciplines scientifiques. Au fur et à mesure que les sciences physiques se sont investies davantage dans une vision quantique mécanique de la réalité et que la science en général est devenue plus éprise et dépendante de la simulation sur ordinateur en tant qu’outil expérimental, le modèle de continuum traditionnel des physiques classique a progressivement perdu du terrain au profit de nouvelles classes de modèles pour lesquels les concepts d’information et de calcul sont essentiels. Appelés « modèles discrets », ils décrivent la réalité en termes de bits, quanta, événements quantiques, opérations de calcul et autres unités discrètes, récursivement liées. Alors que les modèles de continuum sont basés sur la notion de continuum, un tout extensible unifié avec un ou plusieurs paramètres de distance pouvant être subdivisés à l’infini de manière à ce que deux points distincts soient séparés par un nombre infini de points intermédiaires, les modèles discrets se distinguent par une reconnaissance réaliste du fait qu’il est impossible de décrire ou de définir un changement ou une séparation d’une manière qui n’implique pas un saut fini soudain dans un paramètre.

Malheureusement, les avantages des modèles discrets, qui font l’objet d’une attention de plus en plus sérieuse de la part des communautés scientifiques et philosophiques, sont contrebalancés par certaines lacunes fondamentales. Non seulement ils présentent des problèmes de mise à l’échelle et de non-localité associés à leur « matériel d’affichage », mais ils sont inadéquats, à eux seuls, pour générer l’infrastructure conceptuelle nécessaire pour expliquer le support, le périphérique ou le tableau dans lequel ils évoluent, ou leurs états initiaux et leur programmation de transition d’état. De plus, ils restent ancrés dans le matérialisme, l’objectivisme et le dualisme Cartésien, qui se sont tous révélés être des obstacles au développement d’une explication complète de la réalité. Le matérialisme exclut arbitrairement la possibilité que la réalité ait un aspect non matériel significatif, l’objectivisme exclut arbitrairement la possibilité que la réalité ait un aspect subjectif significatif, et bien que le dualisme Cartésien n’exclue techniquement aucun des deux, il nie arbitrairement que les aspects mentaux et matériels, ou subjectifs et objectifs, de la réalité partagent une substance commune.5

On pourrait presque avoir l’impression que les deux seuls choix possibles sont le modèle classique, auquel la théorie quantique a été fixée avec à peu près le même degré de cohérence que des bois sur un lièvre, et les nouveaux modèles discrets, qui se veulent plus alignés avec la théorie quantique mais échouent sur le bas-côté de la route vers un nouveau type de cosmologie quantique qu’ils semblent promettre de façon insolite. Car de telles affirmations présentent une ironie évidente : la réalité classique est précisément celle sur laquelle sont définies l’information et le calcul ! Comme la réalité classique elle-même, une entité bien définie incapable de rendre compte de sa propre genèse, l’information et le calcul sont des aspects bien définis et non auto-génératifs de la réalité telle qu’elle se présent observationnellement à nous à un stade avancé de son existence. Ils invitent donc aux mêmes questions que la réalité classique : comment et par quoi ont-ils été définis et générés à l’origine ? Sans une réponse à cette question, on ne gagne pas grand-chose à remplacer une sorte de réalité par l’autre.

Certains ont peut-être ressenti, alors qu’ils regardaient l’histoire des grandes théories et des nouveaux paradigmes se dérouler ces dernières années, comme s’ils étaient obligés de regarder la même série, ou de lire le même roman, mille fois en successions fastidieuses sans rien de plus qu’une révision mineure occasionnelle de l’intrigue ou des personnages. Cependant, il y a une troisième alternative qui est jusqu’ici restée en arrière-plan. Elle fournit exactement ce qui est requis à la lumière de toute thèse et antithèse : une synthèse. Cette synthèse donne une nouvelle classe de modèle(s)6 préservant les meilleures caractéristiques de la thèse et de l’antithèse, le continuum et le quantum, en les unissant par le biais de principes généraux et de préférence auto-évidents. Cet article présente cette nouvelle classe à travers un seul exemple, le Modèle Théorique-Cognitif de l’Univers (CTMU).

Déterminisme, indéterminisme et troisième option

Comme les mathématiques, la science et la philosophie d’où ils découlent, le continuum classique et les modèles discrets modernes de la réalité autorisent généralement exactement deux modes de déterminismes : la causalité externe et l’acausalité ou « hasard ». Étant donné un objet, un événement, un ensemble ou un processus, on suppose généralement qu’il s’est produit d’une ou des deux manières suivantes : (1) son existence est due à quelque chose d’antérieur et d’extérieur à lui; (2) il est sans cause et a surgi spontanément et inutilement d’une manière à-partir-de-rien, sortie-du-chapeau, comme par magie. Une hypothèse similaire est faite en ce qui concerne son comportement : soit il est contrôlé par des lois qui sont invariantes à son égard et donc existentiellement externes à celui-ci (même si elles le contrôlent par sa structure et ses propriétés intrinsèques), ou bien il se comporte d’une manière totalement aléatoire et incontrôlée. Cela a donné lieu à une dichotomie : déterminisme versus hasard, ou une absence totale de causalité versus causalité par des lois ultimement indépendantes de l’entité déterminée.

Déterminisme et indéterminisme… à première vue, il ne semble pas y avoir de terrain commun. Les événements sont soit causalement liés, soit ils ne le sont pas, et s’ils ne le sont pas, alors l’avenir semble totalement indépendant du passé. Soit nous utilisons la causalité pour relier les points et dresser une image cohérente du temps, soit nous nous contentons d’une diffusion aléatoire de points indépendants sans motif spatial ou temporel et donc sans signification. Au risque d’un euphémisme, les effets philosophiques de cette dichotomie supposée ont été extrêmement corrosifs. Aucun univers qui existe ou évolue strictement en fonction d’un déterminisme externe, du hasard ou d’une alternance des deux ne peut offrir beaucoup de sens. Là où la liberté et la volonté sont hors de propos, il en va de même pour la majeure partie de l’expérience et de l’individualité humaines.

Mais après tout, il y a une autre possibilité : l’autodéterminisme. L’autodéterminisme est comme un bord détourné séparant les pôles de la dichotomie précédente… un bord réflexif, et donc fermé, dont la formation n’implique ni lois préexistantes ni structure externe. Il s’agit donc du type d’attribution causale approprié pour un système parfaitement autonome. L’autodéterminisme est un concept profond mais subtil, dû en grande partie au fait que, contrairement au déterminisme ou au hasard, il est une source de sens authentique. Lorsqu’un système détermine sa propre composition, ses propriétés et son évolution indépendamment de lois ou des structures externes, il peut déterminer son propre sens et s’assurer de son auto-configuration que ses habitants y sont impliqués de manière cruciale.

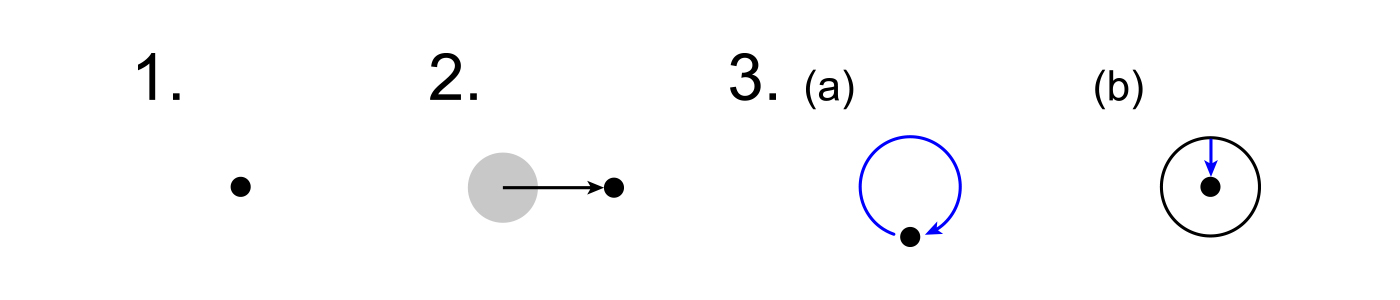

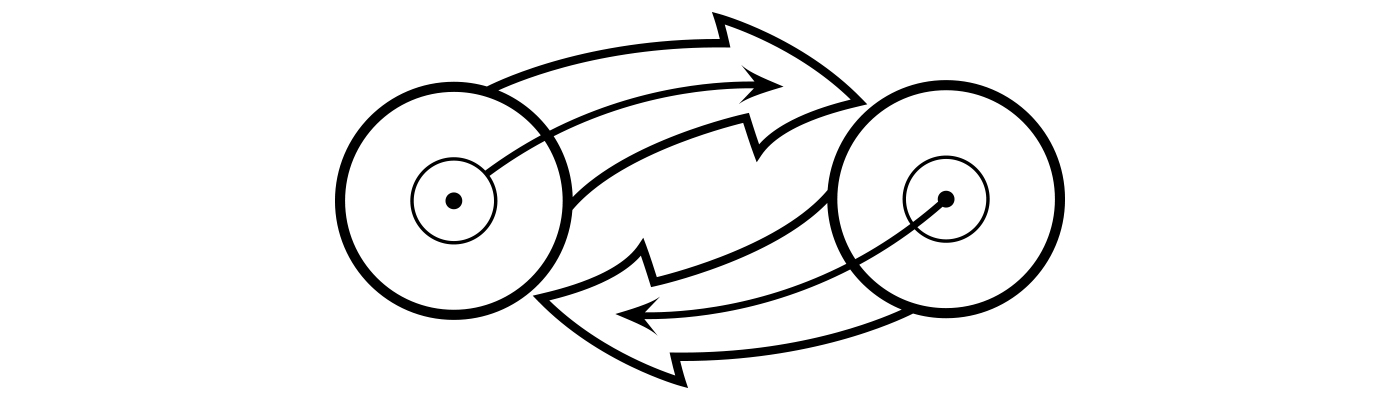

Diagramme 1 : 1. Indéterminisme 2. Déterminisme externe 3a. Autodéterminisme 3b. Autodéterminisme intrinsèque (l’aspect effectif de l’objet ou de l’événement a simplement été déplacé à l’intérieur de l’aspect causal, permettant l’internalisation de la flèche bleue du déterminisme et rendant la causalité endomorphique.)

Si le déterminisme correspond à une flèche de causalité pointant vers un événement à partir d’un support environnant, l’indéterminisme ne correspond à aucune flèche (acausalité) et l’autodéterminisme à une flèche bouclée ou à un complexe de flèches impliquant une rétroaction quelconque. Mais la rétroaction cybernétique, qui implique des informations transmises aux contrôleurs et aux entités régulées via un support conducteur ou transmissif, n’a pas de sens lorsque de telles entités n’existent pas déjà et qu’aucun protocole sensoriel ou actionnant n’a encore été fourni. En ce qui concerne l’origine de tout système autodéterminant, parfaitement autonome, la rétroaction d’information est de nature ontologique et est donc plus que cybernétique. En conséquence, la rétroaction ontologique porte la description de « précybernétique » ou « métacybernétique ». En effet, en raison de leurs relations particulièrement étroites, les théories de l’information, du calcul et de la cybernétique s’inscrivent dans le prolongement d’une extension convergente… une extension qui peut, dans un contexte de théorie de la réalité, jeter l’essentiel des bases d’une extension convergente de tout ce qui est couvert par leurs formalismes respectifs.7

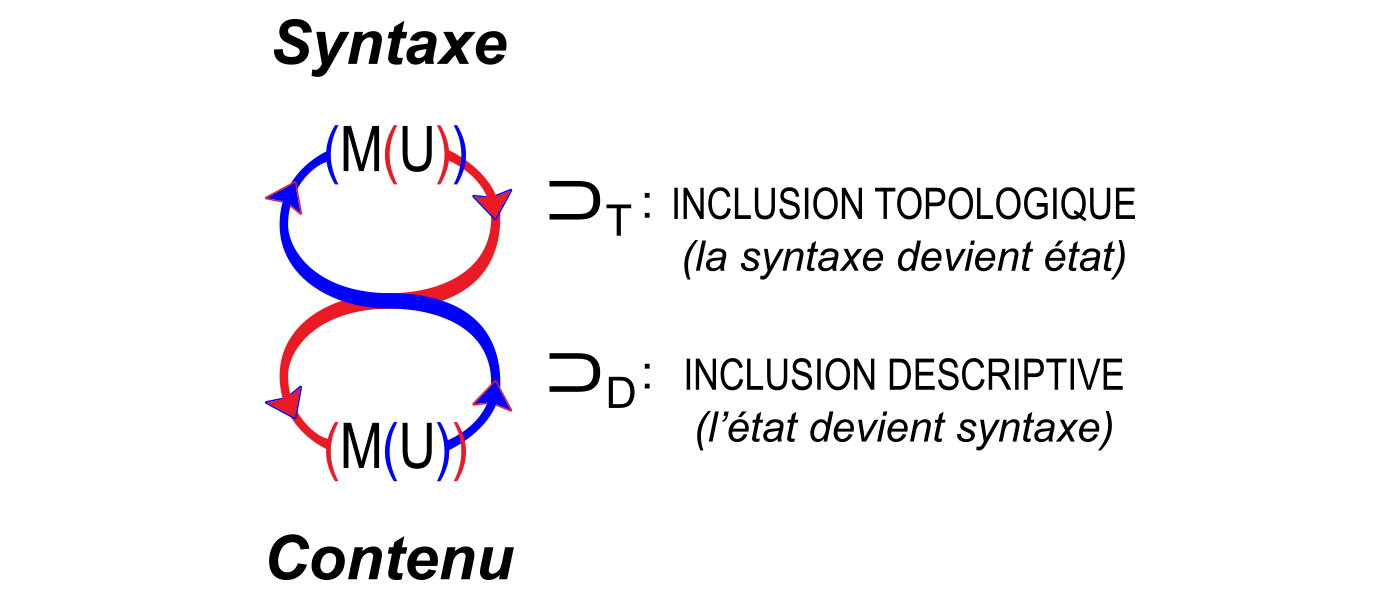

La rétroaction ordinaire, décrivant l’évolution des systèmes mécaniques (et avec un peu moins de succès, biologique), est cyclique ou récursif. Le système et ses composants font régulièrement appel à des structures internes, à des routines et à des mécanismes d’actionnement pour acquérir des entrées, générer les informations internes correspondantes, les communiquer en interne et les traiter, et évoluer vers les états appropriés en fonction des entrées et de la programmation. Cependant, lorsque l’objet consiste à décrire l’évolution d’un système d’un état dans lequel il n’y a aucune information ou programmation (syntaxe de traitement de l’information), un nouveau type de rétroaction est requis: la rétroaction télique.

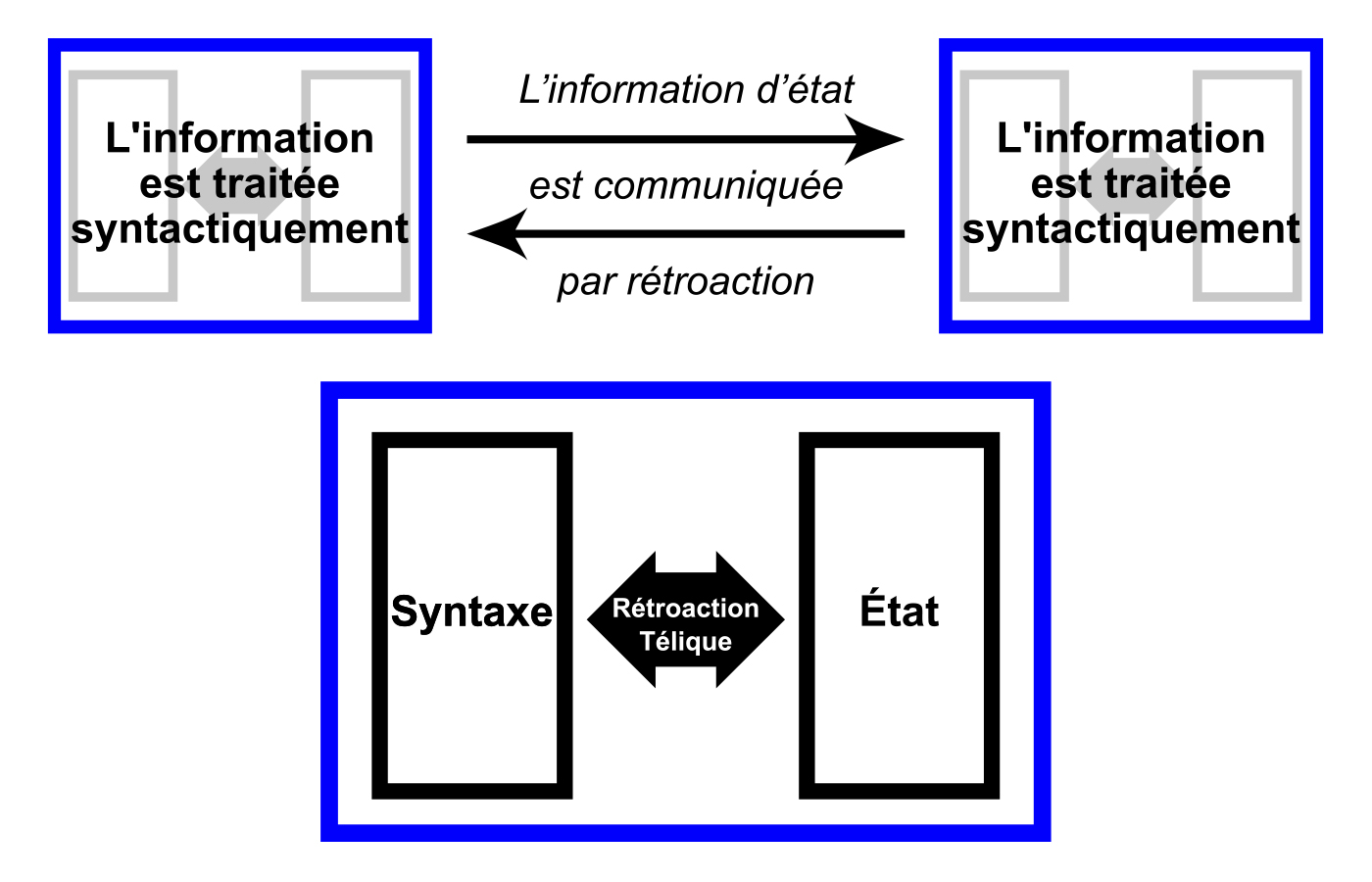

Diagramme 2 : Le diagramme supérieur illustre les rétroactions cybernétiques ordinaires entre deux transducteurs d’information qui échangent et agissent sur des informations reflétant leurs états internes. La structure et le comportement de chaque transducteur sont conformes à une syntaxe ou à un ensemble de règles structurelles et fonctionnelles qui déterminent son comportement pour une entrée donnée. Dans la mesure où chaque transducteur est soit déterministe, soit non déterministe (dans les limites d’une contrainte syntactique), le système est soit déterministe, soit « aléatoire jusqu’au déterminisme »; il n’y a pas de disposition pour l’auto-causation en dessous du niveau systémique. Le diagramme inférieur, qui s’applique aux systèmes cohérents d’auto-conception, illustre une situation dans laquelle la syntaxe et l’état sont plutôt déterminés en tandem conformément à une fonction d’utilité généralisée attribuant des valeurs différentielles, mais à l’échelle intrinsèque, à diverses relations syntaxe-état possibles. Une combinaison de ces deux scénarios est partiellement illustrée dans le diagramme supérieur par les ombres grises dans chaque transducteur.

La monnaie du rétroaction télique est un paramètre quantifiable d’auto-sélection, une utilité généralisée, une propriété généralisée de loi et d’état dans la maximisation de laquelle ils subissent un raffinement mutuel (notez que l’utilité généralisée est auto-descriptive ou autologue, définie intrinsèquement et rétroactivement dans le système, et « pré-informationnelle » dans le sens où elle n’attribue aucune propriété spécifique à un objet spécifique). À travers la rétroaction télique, un système s’auto-configure rétroactivement en appliquant réflexivement une « fonction d’utilité généralisée » à son potentiel existentiel interne ou à ses futurs possibles. En effet, le système s’amène à l’existence comme un moyen de communication intemporel entre son passé et son futur, selon lequel la loi et l’état, la syntaxe et le contenu informationnel, se génèrent et s’affinent mutuellement à travers le temps pour maximiser l’auto-utilité systémique. Cela définit une situation dans laquelle la véritable identité temporelle du système est un point d’équilibre temporel distribué, qui est à la fois entre et inclusif au passé et au futur. En ce sens, le système est intemporel ou atemporel.

Un système qui évolue au moyen de la récursion télique – et en fin de compte, chaque système doit être ou être incorporé dans un tel système en tant que condition d’existence – n’est pas simplement calculatoire, mais protocalculatoire. C’est-à-dire que son niveau de traitement principal configure son niveau de traitement secondaire (calculatoire et informationnel) par récursion télique. La récursion télique peut être considérée comme le mécanisme autodéterminant, non seulement de la cosmogonie, mais aussi comme une forme naturelle et scientifique de la téléologie.

Cependant, avant d’approfondir ces idées, assistons à une petite séance d’orientation basée sur la vision remarquablement pénétrante de John Archibald Wheeler, scientifique de renom et théoricien de la réalité, dont le nom est pratiquement synonyme de physique moderne.

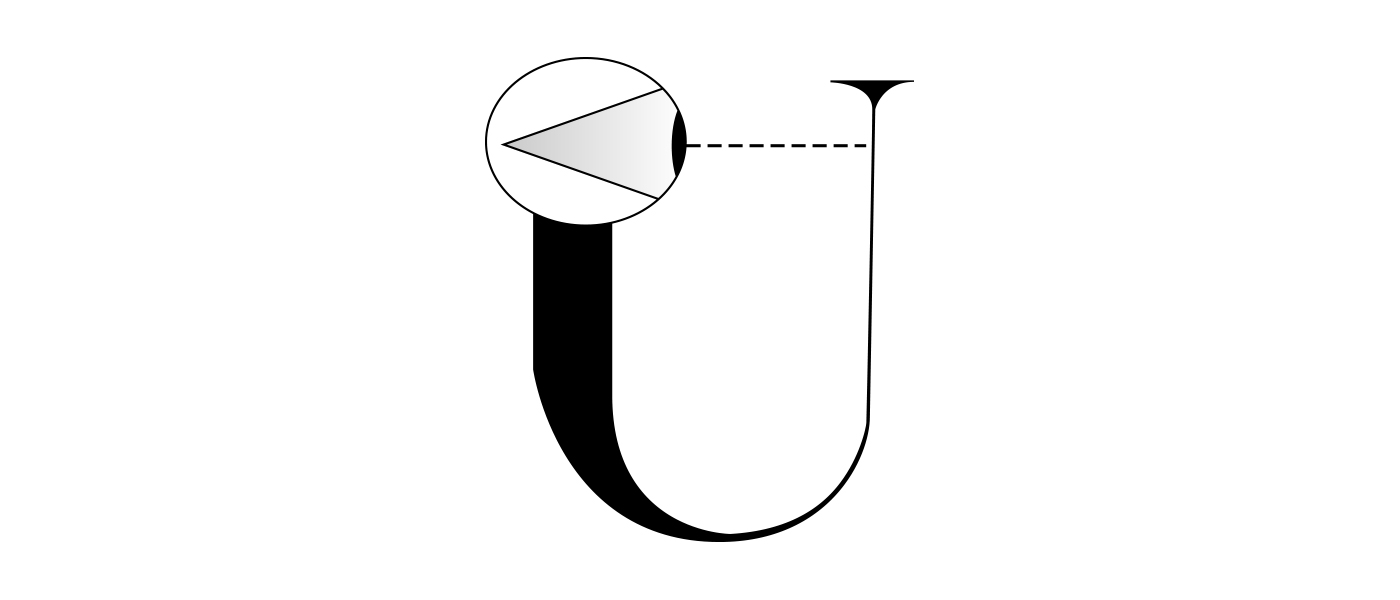

L’avenir de la théorie de la réalité selon John Wheeler

En 1979, le célèbre physicien John Wheeler, après avoir inventé l’expression « trou noir », en fit un bon usage philosophique dans le titre d’un article exploratoire intitulé Beyond the Black Hole8, dans lequel il décrit l’univers comme un circuit auto-excité. Le document inclut une illustration dans laquelle un côté d’une lettre majuscule U, représentant ostensiblement l’Univers, est doté d’un œil large et à l’air plutôt intelligent qui regarde attentivement l’autre côté, qu’il acquiert apparemment par l’observation en tant qu’information sensorielle. Grâce au placement, l’œil représente l’aspect sensoriel ou cognitif de la réalité, peut-être même un spectateur humain dans l’univers, tandis que la cible perceptuelle de l’œil représente l’aspect informationnel de la réalité. En vertu de ces aspects complémentaires, il semble que l’univers puisse dans un certain sens, mais pas nécessairement dans son usage courant, être décrit comme « conscient » et « introspectif »… peut-être même « infocognitif ».

Diagramme 3 : L’Univers en tant que circuit auto-excité. Cliquez pour l’animation [Diagramme adapté de Wheeler, J. A., « Beyond the Black Hole », dans Some Strangeness in the Proportion: A Centennial Symposium to Celebrate the Achievments of Albert Einstein, Woolf, H. (éd.), Addison-Welsley, 1980. p. 362.]

Wheeler, un représentant éminent et hautement compétent de ceux qui sont familiers des avantages et les inconvénients de nos modèles actuels de réalité, n’est pas parvenu à l’illustration donnée en tant que spéculation isolée. En conjonction avec plusieurs autres concepts de Wheeler, l’« Univers Participatif », la « Loi sans Loi » et le « It from Bit », le circuit auto-excité constitue un programme préliminaire, mais bien pensé, pour décrire l’univers physique. Selon son mandat, la véritable description de la réalité doit posséder deux caractéristiques nouvelles qui ne se retrouvent dans aucun paradigme dominant : (1) réflexivité structurelle et dynamique globale ou « circuit auto-excité », la perception faisant partie intégrante de la fonction d’auto-reconnaissance de la réalité ; (2) équivalence matière-information, identification (jusqu’à l’isomorphisme) de la réalité physique concrète avec l’information, monnaie abstraite de la perception. Ensemble, ces caractéristiques constituent une extension cosmologique de la cybernétique ou, de manière équivalente, une extension métacybernétique de la cosmologie.

Wheeler caractérise ces quatre concepts comme suit :

Le circuit auto-excité : Un univers participatif est un circuit auto-excité dans le sens où il implique en rétroaction (perceptuel, ontologique) les observateurs. C’est une « boucle logique » dans laquelle « la physique donne lieu à la participation de l’observateur; la participation de l’observateur donne lieu à l’information; et l’information donne naissance à la physique. »9

L’Univers Participatif : les processus cognitifs et perceptuels des observateurs font partie intégrante de la rétroaction auto-excitante de la réalité. Ceci est affirmé par le Principe Participatif (ou Principe Anthropique Participatif), que Wheeler décrit de manière informelle comme suit : « Plus fort que le Principe Anthropique est ce que je pourrais appeler le Principe Participatif. Selon celui-ci, nous ne pourrions même pas imaginer un univers qui ne contienne quelque part et pendant un certain temps des observateurs, car les propres matériaux de construction de l’univers sont ces actes d’observation-participation… Ce principe participatif prend pour fondement le point absolument central du quantum : aucun phénomène élémentaire n’est un phénomène tant qu’il ne s’agit pas d’un phénomène observé (ou inscrit) » [emphase ajoutée]. Notez qu’à un certain niveau de généralité, la dernière phrase identifie l’observation avec l’inscription et assimile donc implicitement la reconnaissance humaine et mécanique : « … un phénomène observé (ou inscrit) ». [Emphase de nouveau ajoutée].10

Loi Sans Loi / Ordre du Désordre: En résumé, rien ne peut être pris pour acquis en matière de cosmogonie. Selon les propres mots du professeur Wheeler: « Pour moi, la plus grande découverte à venir sera de trouver comment cet univers, né d’un Big Bang, a développé ses lois de fonctionnement. J’appelle cela « la Loi Sans Loi » [ou « l’Ordre du Désordre »]. (…) Imaginez l’univers avec toutes ses régularités et ses lois en train de naître de quelque chose de complètement désordonné, pêle-mêle et aléatoire… Si vous étiez le Seigneur qui construisait l’univers, comment l’auriez-vous fait ? Il est inspirant de lire la vie de Charles Darwin et de penser comment la division des règnes végétal et animal, toute cette myriade d’ordres, est née des miracles de l’évolution, de la sélection naturelle et de la mutation fortuite. Pour moi, c’est une indication merveilleuse que vous pouvez obtenir l’ordre en commençant par le désordre. »11

It From Bit : La réalité se construit et/ou se produit sous la forme d’informations résidant dans des événements quantiques. Comme le résume Wheeler dans son article Information, Physics, Quantum: The Search for Links, « … chaque quantité physique, chaque chose, tire sa signification ultime de bits, d’indications binaires oui-ou-non… ». Il aborde ensuite ce concept en détail en proposant trois questions, quatre « non » et cinq « indices » sur le caractère informationnel-quantique de la réalité. Les questions sont les suivantes : (1) Comment survient l’existence ? (2) Comment survient le quantum ? (3) Comment survient le « monde unique » composé de nombreux observateurs-participants ? Les non, pièges séduisants à éviter pour répondre aux trois questions, ne comprennent aucune tour de tortues, aucune loi, aucun continuum, et aucun espace ou temps. Et les indices, qui éclairent le chemin vers les vraies réponses, incluent la limite d’une limite est zéro; Pas de question ? Pas de réponse ! ; Le Principe Super-Copernicien; « La Conscience » (y compris les guillemets); et plus est différent.12

Nous allons maintenant donner un bref compte rendu de ces questions, précautions et indices.

Comment survient l’existence ? La portée ontologique et cosmologique de cette question est évidente; sous une forme ou une autre, elle a miné les philosophes depuis des temps immémoriaux. Tel qu’interprété par Wheeler, cela conduit à quatre conclusions inévitables. « (1) Le monde ne peut pas être une machine géante, gouvernée par un quelconque continuum de loi physique préétabli. (2) Au niveau microscopique, il n’existe pas d’espace ou de temps ou de continuum espace-temps. (3) La fonction de probabilité familière ou fonctionnelle, et l’équation d’onde ou équation d’onde fonctionnelle, de la théorie quantique standard fournissent de simples idéalisations de continuum et, en raison de cette circonstance, dissimulent la source d’information-théorique à partir de laquelle elles sont dérivées. (4) Aucun élément dans la description de la physique ne se montre aussi près d’être primordial que le phénomène quantique élémentaire, c’est-à-dire l’acte élémentaire-intermédiaire qui consiste à poser une question physique du type oui-ou-non et à obtenir une réponse ou, en bref, l’acte élémentaire de participation d’un observateur. Autrement dit, chaque grandeur physique, chaque chose, tire sa signification ultime de bits, d’indications binaires oui-ou-non, conclusion que nous résumons dans l’expression it from bit. »13

Comment survient le quantum ? Pourquoi l’univers est-il constitué d’événements quantiques apparemment propter hoc non déterministes, mais post hoc informationnels ? Comme le remarque Wheeler, « La physique quantique nécessite une nouvelle vision de la réalité » 14 Quelle est donc la relation logique exacte entre le quantum et la nouvelle vision de la réalité qu’elle exige ? Quelle est cette nouvelle vision et comment le quantum s’y intègre-t-il ?

Comment survient le « monde unique » parmi de nombreux observateurs-participants ? Dans la mesure où le terme « observateurs-participants » englobe les scientifiques et les autres êtres humains, cette question invite une interprétation quasi anthropologique. Pourquoi un univers composé d’observateurs distincts dont les programmes et les impératifs de survie sont parfois contradictoires devrait-il afficher une unité structurelle et nomologique ? Lorsque les observateurs sont capables de créer des événements dans la variété unitaire globale de leur univers commun, pourquoi ne le feraient-ils pas strictement pour eux-mêmes, chacun dans son propre univers, et jamais les deux ne se rencontreraient ? Lorsque le concept observateur-participant est généralisé pour inclure des systèmes non anthropiques de transduction d’informations, qu’est-ce qui maintient l’ensemble de ces systèmes dans une seule et même réalité ?

Aucune tour de tortues : Emprunté à William James, cet aphorisme signifie « pas de régression infinie vers des domaines et principes de causalité toujours antérieurs ». À cela, nous pourrions assimiler une version mise à jour d’un aphorisme bien connu, attribué à Harry Truman : « Le pouvoir explicatif s’arrête ici », où ici fait référence à cette réalité que nous habitons et observons. Wheeler ajoute à cela une idée cruciale: « À l’infini, aucune autre alternative n’est évidente qu’une boucle, telle que : la physique donne lieu à la participation de l’observateur; la participation de l’observateur donne lieu à l’information; et l’information donne naissance à la physique »15. Seule une telle boucle ontologique est capable de former un collet suffisamment large et fort pour le ceinturage théorique de la réalité; la tâche à accomplir est donc de trouver un moyen de le fabriquer et un support par lequel le manier.

Aucune Loi : Comme le dit Wheeler, « L’univers doit être né… sans même un plan préexistant… seul un principe d’organisation qui ne serait aucune organisation du tout semblerait s’offrir à lui-même » 16. Ou pour réitérer: « Le monde ne peut pas être une machine géante, gouvernée par un quelconque continuum de loi physique préétabli. »

Aucun continuum : le vénérable continuum d’analyse et de mécanique est une chimère mathématique et physique. (Habituellement associé à l’ensemble des nombres réels, un continuum est un ensemble extensible unifié avec un paramètre de distance pouvant être subdivisé à l’infini de manière à ce que deux points distincts soient séparés par un nombre infini de points intermédiaires.) Comme le dit Wheeler: « Un demi-siècle de développement dans le domaine de la logique mathématique a clairement montré qu’il n’y avait aucune preuve à l’appui de la croyance en le caractère existentiel du continuum des nombres 17 ». Quelques nombres, par exemple les irrationnels tels que √2 ne peuvent pas être calculés avec précision et ne correspondent donc à aucun emplacement physiquement significatif sur une droite numérique ou une trajectoire physique; ils ont une existence uniquement abstraite.

Aucun espace ou temps : Encore une fois, « Au niveau microscopique, il n’existe pas d’espace ou de temps ou de continuum espace-temps ». Au niveau submicroscopique, le principe d’incertitude de Heisenberg transforme l’espace-temps en une « mousse quantique » apparemment chaotique, jetant le doute sur la connectivité de l’espace et son ordinalité. Wheeler cite Einstein dans une veine kantienne: « Le temps et l’espace sont des modes par lesquels nous pensons, et non des conditions dans lesquelles nous vivons », considérant ces modes comme pouvant être dérivés d’une théorie propre à réalité en tant que fonctions idéalisées d’un continuum idéalisé: « Nous n’introduirons le temps dans aucun compte-rendu profond de l’existence. Nous devons dériver le temps (et seulement le temps du continuum idéalisé). De même avec l’espace. »18

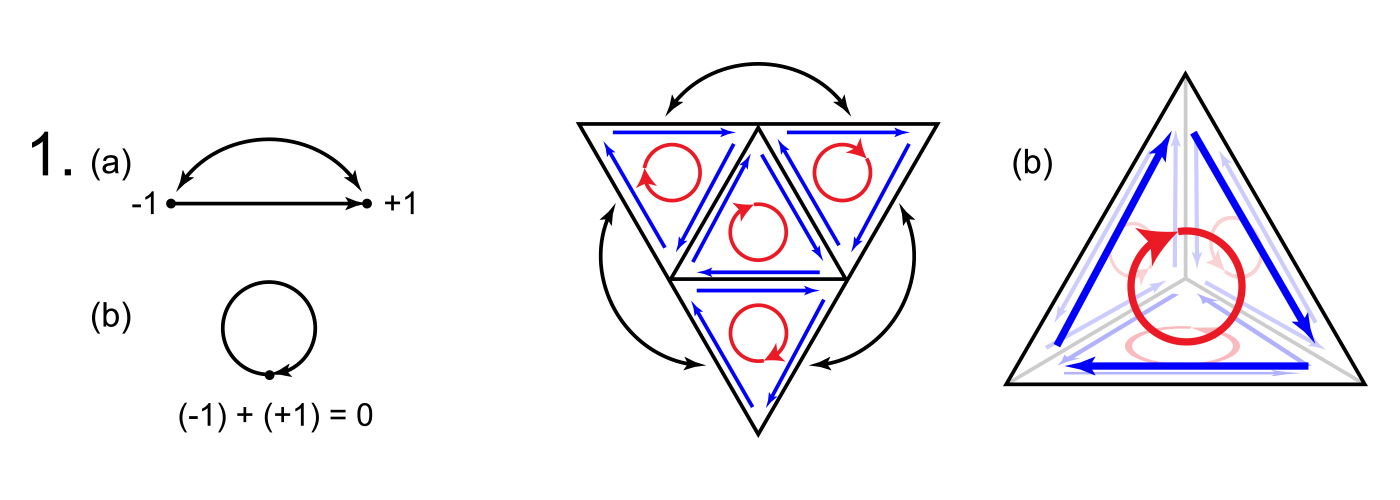

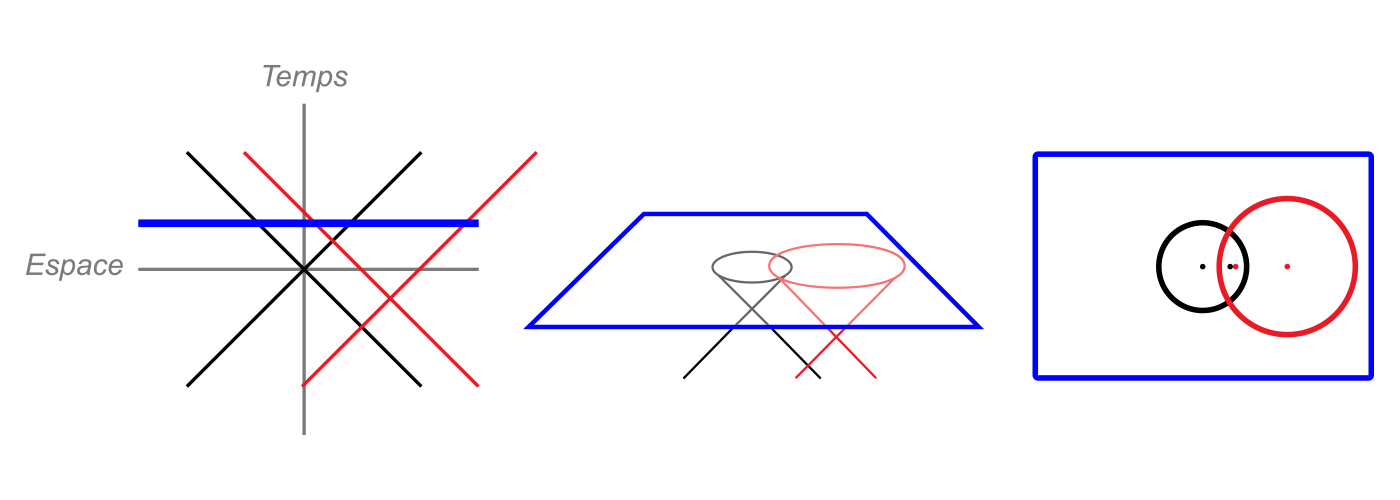

La limite d’une limite est zéro : En substance, cette notion intuitive de la topologie algébrique dit que les structures fermées incarnent un certain type de symétrie « auto-annulable ». Ceci peut être illustré en trois dimensions par un tétraèdre dont le « bord » simplicial incorpore ses quatre faces triangulaires équilatérales. Pour trouver le bord de ce bord, vous devez mesurer les arrêtes orientés dans le sens horaire – ou antihoraire – autour de chaque face, mesurant ainsi chaque arrête du tétraèdre deux fois dans des directions opposées. Étant donné que la somme des mesures s’annule maintenant à 0 à chaque arrête, le bord du bord du tétraèdre est égale à zéro. Cette propriété s’avère avoir de nombreuses applications en physique, en particulier dans la théorie des champs, en ce qui concerne « l’emprise » réciproque de la matière sur l’espace et de l’espace sur la matière (ou, de manière moins colorée, la relation entre l’espace et la matière). Dans la vision de Wheeler, son ubiquité « inspire l’espoir que nous allons un jour compléter les mathématiques de la physique et tirer le tout de rien, toute loi d’aucune loi » 19. Ainsi, il est étroitement lié à la loi sans loi et à la création dite ex nihilo.

Diagramme 4 : 1a : Le bord d’un segment de droite 1-dimensionnelle orientée est constitué de ses extrémités 0-dimensionnelles, qui séparent la ligne de son complément (l’espace qui l’entoure). Le point initial représente la « dette » requise pour démarrer la ligne et reçoit donc une valeur de -1, tandis que le point terminal représente le « paiement » pour compléter la ligne et reçoit une valeur de +1. Lorsque les points initial et terminal de la ligne sont identifiés comme indiqué par la flèche incurvée, il en résulte une ligne fermée délimitant un disque plan (1b). Comme les points d’extrémité coïncident maintenant, ils totalisent 0 et ne séparent plus la ligne de son complément; ainsi, le bord 0-dimensionnel du bord 1-dimensionnel du disque 2-dimensionnel est 0. 2a: Une zone triangulaire peut être décomposée en 4 zones triangulaires plus petites. L’introduction d’une orientation uniforme (dans ce cas, dans le sens horaire) par rapport aux zones (flèches rouges) confère la même orientation au périmètre extérieur (flèches bleues extérieures), recréant la situation de 1b (remarquez que les flèches bleues situées à côté de chaque arrête intérieure pointent en direction opposée et sont donc annulées). De nouveau, les points initial et terminal du périmètre coïncident et s’annulent à 0 où qu’ils se trouvent. Lorsque les segments périphériques adjacents sont identifiés comme indiqué par les flèches extérieures, le triangle se plie en un tétraèdre (2b). Ses faces forment un bord 2-dimensionnel fermé séparant son intérieur 3-dimensionnel de son extérieur, tandis que ses arrêtes forment un bord fermé 1-dimensionnel séparant ses faces les unes des autres. Mais maintenant, les flèches bleues s’annulent à chaque arrête et le bord 1-dimensionnel du bord 2-dimensionnel du tétraèdre est 0. Ainsi, pour le disque 2D et le tétraèdre 3D, le bord du bord est 0. Bien que les physiciens utilisent souvent cette règle pour expliquer la conservation de l’énergie-moment (ou comme l’appelle Wheeler, « momenergy » 20), elle peut être interprétée plus généralement en termes d’information et de contrainte, ou d’état et de syntaxe. En d’autres termes, le bord est analogue à une contrainte qui sépare un attribut intérieur satisfaisant la contrainte d’un attribut extérieur complémentaire, créant ainsi une distinction informationnelle.

Pas de question ? Pas de réponse ! Dans une expérience quantique, le dispositif de mesure et son emplacement correspondent à une question et le résultat à sa réponse. L’existence de la réponse, constituée d’informations sur l’état, est fondée sur le fait de poser la question (ou de l’occurrence de la mesure), et le type de réponse reçue dépend du type de question posée et de la manière dont elle est posée. Le monde est donc composé d’événements de mesure dans lesquels des informations sont échangées par des objets, l’un ou les deux « posant une question » et l’un ou les deux « donnant une réponse ». La question et la réponse, la stimulation et l’observation d’un événement, ne peuvent être séparées sur le plan ontologique et elles ne peuvent pas être protégées de l’influence de l’environnement. À la racine de ce critère sont l’incertitude quantique et la complémentarité, pierres fondatrices de la mécanique quantique.

Le Principe Super-Copernicien : De même que Copernic a remplacé le géocentrisme par l’héliocentrisme, montrant par extension qu’aucun lieu particulier dans l’univers n’est spécial et répudiant ainsi le « centrage-ici », le Principe Super-Copernicien dit qu’aucun moment particulier dans le temps n’est spécial, répudiant le « centrage-maintenant ». Essentiellement, cela signifie que lorsque l’observateur-participation fonctionne rétroactivement, la charge de la participation est effectivement distribuée dans le temps. Ainsi, bien que la « taille en bits » de l’univers soit trop importante pour avoir été entièrement générée par les observateurs-participants qui ont existé jusqu’à présent, les générations futures d’observateurs-participants, représentant éventuellement des modes d’observation-participation autres que celle associé à l’observation humaine, ont pesé et pèsent maintenant depuis l’avenir. (La pertinence de ce principe par rapport au Principe Anthropique Participatif va de soi.)

« La Conscience » : Wheeler souligne la difficulté d’établir une distinction générale entre la forme de traitement de l’information caractéristique des humains, et cette caractéristique de divers systèmes et dispositifs complexes qui peuvent ou non être « conscience ». « La ligne entre l’inconscient et le conscient commence à s’estomper… », déclare-t-il; « Nous devrons peut-être un jour élargir la portée de ce que nous entendons par un « qui ». » Le terme qui, suggère-t-il, est trop spécifique à l’homme, à la vie et à la conscience; ses connotations anthropiques sont anticoperniciennes, tandis que les concepts de vie et de conscience sont sujets à révision à mesure que la science avance. « Il semblerait plus raisonnable, » suggère-t-il, « de rejeter pour le moment les accents sémantiques de « qui », d’explorer et d’exploiter les connaissances à tirer des expressions « communication » et « communication employée pour établir un sens ». »21

Plus est différent : le potentiel de complexité augmente avec la cardinalité; avec un grand nombre d’éléments vient la variété combinatoire et le potentiel d’une sorte de structure logique à plusieurs niveaux qui caractérise les organismes biologiques et les ordinateurs modernes. C’est un précepte fondamental de la théorie de la complexité. Wheeler pose la question suivante : « Allons-nous un jour comprendre le temps et l’espace ainsi que toutes les autres caractéristiques qui distinguent la physique – et l’existence elle-même – en tant qu’organes auto-générés d’un système d’information auto-synthétisé ? » 22

Ensemble, ces slogans rigides, questions, précautions et indices constituent un appel à une nouvelle souche de théorie de la réalité, un modèle conceptuel unifié pour nos pensées et observations. Combien de modèles actuellement retenus répondent à cet appel ? La réponse est, bien sûr, « presque aucun ». Si certains d’entre eux semblent répondre à une ou deux des questions et respecter un ou deux des critères, aucune n’est toutefois proche de tous les aborder. Ce que chaque modèle a été obligé de donner pour répondre à un sous-ensemble de critères a coûté cher en termes de respect des autres. Nous avons donc une thèse et une antithèse sous forme de physique classique et de modèles quantiques discrets, mais parce que toute la profondeur de la relation entre les deux est insondable, aucune synthèse. Presque tout le monde semble reconnaître la justesse des idées de Wheeler, mais les relations hiérarchiques supérieures requises pour rassembler toutes ces informations dans une vision d’ensemble se sont révélées insaisissables. La difficulté logique de répondre à toutes les questions et de satisfaire tous les critères en même temps, en parallèle, à l’aide de concepts intégrés logiquement traitables, était tout simplement prohibitive.

Cette situation peut-elle être redressée ?

Quelques principes supplémentaires

Bien que les idées concernant la base idéale et/ou perceptuelle de la réalité remontent à des millénaires, nous pourrions tout aussi bien commencer par certains de leurs partisans les plus récents dans un souci de continuité. Premièrement, Descartes a postulé que la réalité est mentale au sens du rationalisme, mais a contredit sa propre thèse en introduisant le dualisme esprit-corps, la notion que l’esprit et la matière sont irréductiblement séparés. L’empiriste Berkeley a alors déclaré que la réalité était de nature perceptuelle, une sorte de croisement entre l’esprit et la matière. On peut le voir en soustrayant mentalement la perception de la conception de la réalité; ce qui reste est de la pure cognition subjective, mais sans aucun grain objectif pour le moulin perceptuel. (Bien que les tentatives de soustraction cognitive de la réalité sur le plan cognitif soient bien plus courantes, elles ressemblent un peu à vouloir montrer qu’une éponge n’est pas mouillée de manière inhérente lorsqu’elle est immergée dans l’eau, elles ne peuvent jamais réussir sur les parties d’entités cognitives.) Hume a ensuite tenté de supprimer complètement la cognition et la causalité, affirmant que l’esprit et la matière sont tous deux inhérents à la perception et n’existent ni en dehors ni l’une sans l’autre.

En se débarrassant de l’esprit, Hume a apporté une autre « contribution » importante à la théorie de la réalité : il a tenté de se débarrasser de la causalité en la considérant comme un artefact cognitif, en appuyant sa thèse sur le problème de l’induction.23 Le problème de l’induction énonce que, comme l’induction empirique implique l’hypothèse préalable de ce qu’elle cherche à établir, à savoir l’uniformité de la nature, la science est circulaire et fondamentalement défectueuse. Le problème de l’induction est tout à fait réel; cela se manifeste dans l’incertitude d’Heisenberg et le problème de l’horizon cosmique, les limites finies des outils scientifiques d’observation microscopique et macroscopique, et explique pourquoi aucune théorie générale de la réalité ne peut jamais être construite de manière fiable par les méthodes empiriques classiques de la science. Malheureusement, de nombreux scientifiques ont soit écarté ce problème, soit abandonné discrètement la recherche d’une théorie véritablement générale, ne servant aucunement les intérêts à long terme de la science. En fait, le problème de l’induction implique simplement qu’une théorie globale de la réalité ne peut être établie que par les méthodes rationnelles des mathématiques, y compris spécifiquement celles de la logique.

En réponse à Berkeley et Hume, Kant a affirmé que la connaissance non traitée qui subsiste lorsque le contenu perceptuel est soustrait possède une structure intrinsèque qui existe avant le contenu; elle comprend les catégories a priori de réalité perceptuelle ou « phénoménale ».24 Malheureusement, soustraire la perception selon les règles kantiennes donne plus que des cognitions non traitées; cela donne aussi des noumènes, des objets absolus ou des « choses en elles-mêmes ». D’un côté du résultat, il y a un isomorphisme perceptuel entre l’esprit et la réalité phénoménale; de l’autre côté, il y a un gouffre au-delà duquel se trouve une réalité nouménale inconnaissable mais néanmoins fondamentale, que Kant considérait évidemment comme le dernier mot de la théorie de la réalité (sous-théologique).

Cependant, l’abîme de Kant est si profond et si large, et interdit si soigneusement tout isomorphisme esprit-réalité, qu’il exclut l’efficacité causale et, par là même, tout autre principe de correspondance compréhensible. Cela implique que les noumènes sont à la fois rationnellement et empiriquement non pertinents pour la réalité cognitive et perceptuelle et qu’ils peuvent donc être éliminés de la théorie de la réalité en toute sécurité. Quel que soit ce que Kant avait à l’esprit quand il a introduit le concept de noumène, sa définition revient essentiellement à un « concept inconcevable » et est donc un oxymore. Quoi qu’il ait réellement voulu dire, nous devons nous fier à autre chose que la métaphysique kantienne pour le trouver. 25

Jusqu’ici, nous avons réussi à réduire la réalité à la réalité phénoménale étudiée par la science, une combinaison de contenu perceptuel et de principes rationnels de cognition. Un scientifique utilise des méthodes empiriques pour effectuer des observations spécifiques, applique les relations cognitives générales issues de la logique et des mathématiques afin de les expliquer, et parvient à traiter la réalité comme un mélange de perception et de cognition. Mais ce traitement manque de quelque chose qui ressemble à une justification explicite. Lorsqu’une série d’observations est expliquée avec une série probable d’équations interprétées, l’adhérence entre l’explicandum et l’explication pourrait tout aussi bien être fournie par un ciment en caoutchouc. C’est-à-dire que les explications et les interprétations scientifiques font coller les observations et les équations d’une manière très mal comprise. Cela fonctionne souvent comme un charme… mais pourquoi ? L’un des principaux objectifs de la théorie de la réalité est de répondre à cette question.

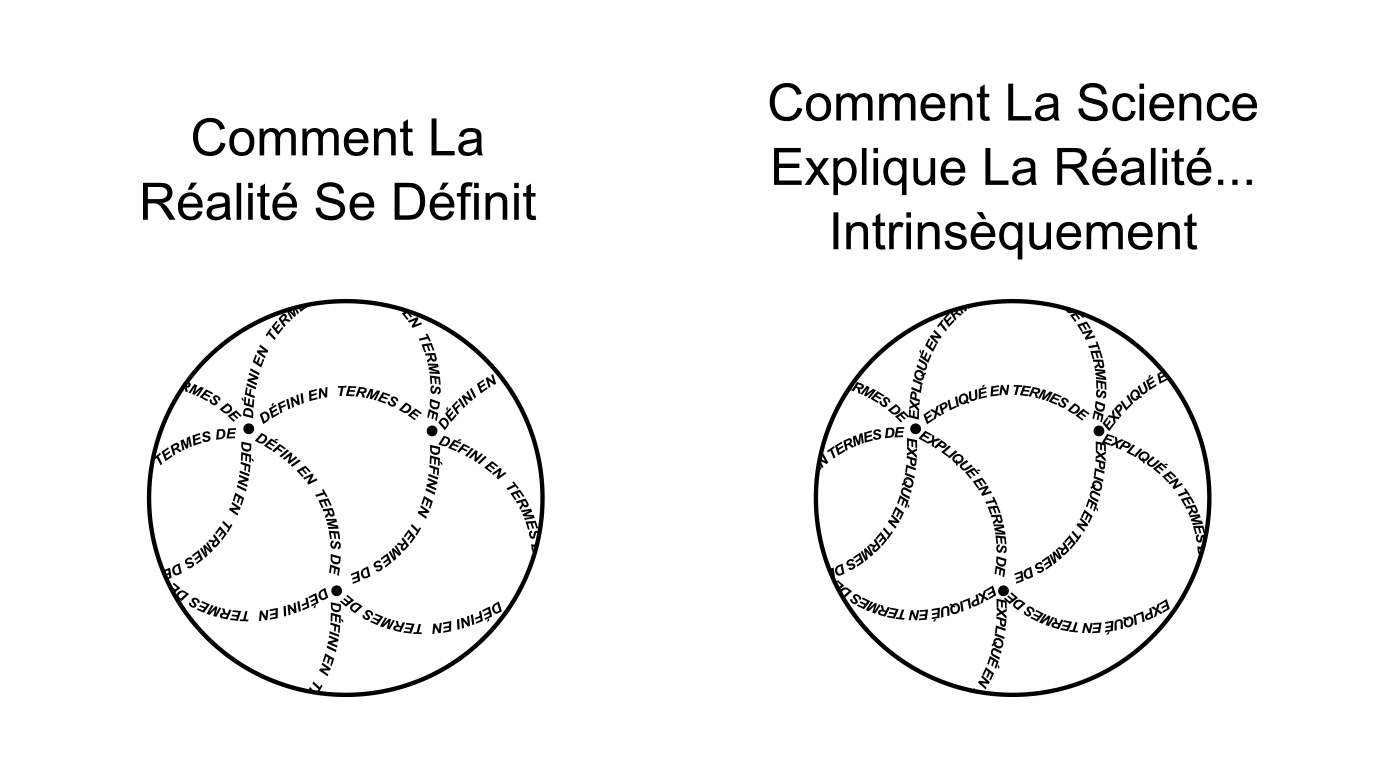

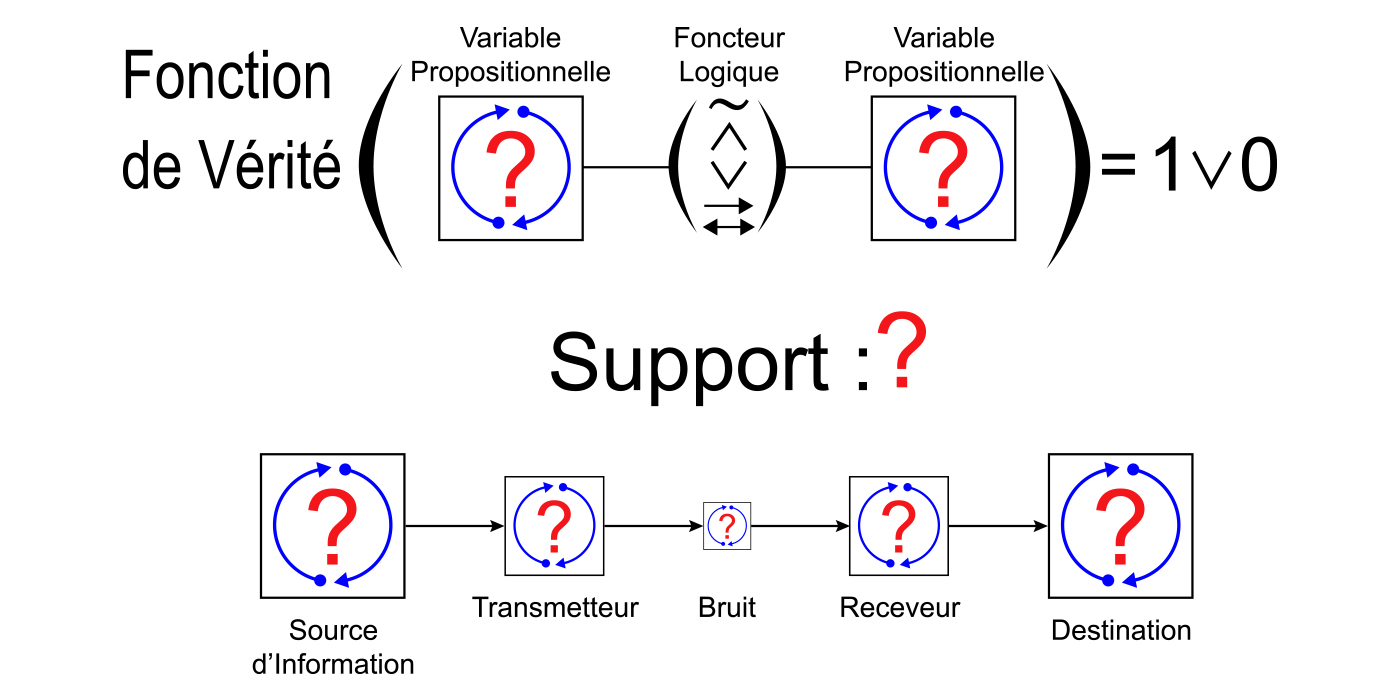

La première chose à noter à propos de cette question est qu’elle implique le processus d’attribution et que les règles d’attribution sont définies en étapes par une logique mathématique. La première étape est appelée logique propositionnelle et contient les règles d’attribution des attributs vrai ou faux, désignant respectivement l’inclusion ou la non-inclusion dans des systèmes cognitifs-perceptuels arbitraires, à des relations hypothétiques dans lesquelles des prédicats sont liés par les foncteurs logiques non, et, ou, implique, et si et seulement si. La logique propositionnelle définit ces foncteurs comme des fonctions de vérité attribuant des valeurs de vérité à de telles expressions indépendamment du contenu (mais pas des valeurs de vérité) de leurs prédicats, créant ainsi une définition circulaire des foncteurs sur les valeurs de vérité et des valeurs de vérité sur les foncteurs. L’étape suivante de l’attribution, la logique des prédicats, attribue des propriétés spécifiques aux objets à l’aide de quantificateurs. Et l’étape finale, la théorie des modèles, comprend les règles permettant d’attribuer des relations complexes de prédicats à des relations complexes d’objets, c’est-à-dire des théories à des univers. De plus, la forme d’attribution appelée définition est expliquée dans une branche logique centrée sur la théorie appelée théorie formalisée, et la mécanique de l’attribution fonctionnelle est traitée dans la théorie de la récursion.

En logique propositionnelle, une tautologie est une expression de variables propositionnelles liées à un foncteur qui est toujours vraie, quelles que soient les valeurs de vérité attribuées à ses variables propositionnelles elles-mêmes. Une tautologie a trois propriétés clés: elle est universellement (syntactiquement) vraie, elle est donc autoréférentielle (vraie même d’elle-même et donc fermée dans une auto-composition récursive) et ses implications restent consistantes dans des opérations inférentielles préservant ces propriétés. C’est-à-dire que chaque tautologie est une circularité auto-consistante de portée universelle, possédant la validité en vertu de la fermeture dans une auto-composition, l’exhaustivité (non-exclusion de la vérité) et la consistance (l’absence de paradoxe insoluble). Mais les tautologies ne sont pas simplement cohérentes en elles-mêmes; elles sont mutuellement consistantes dans une composition mutuelle, faisant de la logique propositionnelle autant une « circularité auto-consistante de portée universelle » que n’importe laquelle de ses tautologies. Ainsi, la logique propositionnelle comprend deux niveaux de tautologie, l’un s’appliquant aux expressions et l’autre aux systèmes théoriques. La logique des prédicats étend ensuite le concept de tautologie aux actes d’attribution spécifiques représentés par les variables propositionnelles (auparavant anonymes), et la théorie des modèles englobe ensuite des actes d’attribution plus complexes impliquant des relations plus complexes.

La théorie de la réalité concerne l’étape d’attribution dans laquelle deux prédicats analogues au vrai et au faux, à savoir le réel et l’irréel, sont attribués à diverses déclarations sur l’univers réel. En ce sens, il est étroitement lié à la logique propositionnelle. En particulier, la logique propositionnelle a quatre propriétés principales à émuler par la théorie de la réalité. La première est la vérité absolue; en tant que définition formelle de la vérité, elle est vraie par définition. Les autres propriétés sont la fermeture, l’exhaustivité et la consistance. C’est-à-dire que la logique est entièrement basée sur, et définie strictement dans les limites, de la cognition et de la perception; elle s’applique à tout ce qui peut être perçu ou conçu de manière cohérente; et elle est par nature consistante, étant conçue de manière à exclure toute inconsistance. C’est la base des mathématiques, le moyen par lequel les propositions sont énoncées, prouvées ou réfutées, et c’est le cœur de la science, garantissant l’intégrité de la méthodologie rationnelle et empirique. Même les logiques dites « non standard », par exemple les logiques modales, floues et à valeurs multiples, doivent être exprimées en termes de logique fondamentale à deux valeurs pour avoir un sens. En bref, la logique à deux valeurs est quelque chose sans laquelle la réalité ne pourrait pas exister. Si elle était éliminée, alors vrai et faux, réel et irréel, et existence et non-existence ne pourraient pas être distingués, et le moindre acte de perception ou de cognition serait tout à fait impossible.

Jusqu’ici, il a été largement admis que la théorie de la réalité peut être recherchée par les mêmes moyens que toute autre théorie scientifique. Mais ce n’est pas tout à fait vrai, car si la science utilise l’équivalent épistémologique de la colle magique pour lier ses théories à ses observations, la théorie de la réalité doit en donner une recette et en justifier les moyens d’application. En d’autres termes, la théorie de la réalité doit décrire la réalité à un niveau qui justifie la science et donc occuper un niveau d’explication plus profond que la science elle-même. Cela signifie-t-il que la théorie de la réalité est mathématique ? Oui, mais puisque les mathématiques doivent être justifiées avec la science, métamathématique serait peut-être une meilleure description… et quand tout est dit et fait, cela revient à la logique pure et simple. Il s’ensuit que la théorie de la réalité doit prendre la forme d’une logique étendue… en fait, une « forme limitante » de la logique dans laquelle la relation entre théorie et univers, jusqu’ici source inépuisable d’ambiguïté modèle-théorique destructrice, est enfin réduite à une forme monique (d’aspect double), court-circuitant le paradoxe du dualisme cartésien et éliminant le fossé épistémologique entre esprit et matière, théorie et univers.

À mesure que la complexité augmente et que les prédicats deviennent des théories, tautologie et vérité deviennent plus difficiles à reconnaître. Parce qu’universalité et spécificité sont contraires dans la pratique sinon en principe, elles sont soumises à une sorte de « décohérence logique » associée à une stratification relationnelle. Comme les prédicats ne sont pas toujours tautologiques, ils sont sujets à divers types d’ambiguïtés; à mesure qu’ils deviennent de plus en plus spécifiques et complexes, il devient de plus en plus difficile de contrôler localement l’héritabilité de la consistante et de conserver localement la propriété de vérité au cours de l’attribution (ou même après coup). Indécidabilité26, insolubilité LSAT et NP-complétude, ambiguïté des prédicats et théorème de Lowenheim-Skolem, ambiguïté observationnelle et thèse de Duhem-Quine27… sont quelques-uns des problèmes qui apparaissent une fois que le prédicat de vérité « décohére » par rapport aux modélisations attributives complexes. C’est pour de telles raisons que la philosophie de la science s’est rabattue sur la doctrine falsificationniste, renonçant à la base tautologique de la logique, transformant effectivement la vérité en statut provisoire et décourageant une pleine appréciation du niveau tautologique-syntactique de la recherche scientifique, et même de la logique et de la philosophie elles-mêmes.

En fait, la validité des théories scientifiques et de la science dans son ensemble dépend absolument de l’existence d’un cadre réalité-théorique fondamental couvrant l’ensemble de la science… une syntaxe fondamentale à partir de laquelle tous les langages scientifiques et mathématiques, et le langage cognitif étendu de la perception elle-même, peut être déplié grammaticalement, croisé et validé. La tautologie, base théorique de la vérité telle qu’elle est incarnée dans la logique propositionnelle, est évidemment au cœur de cette syntaxe. En conséquence, la théorie de la réalité doit être développée par l’amplification de cette syntaxe tautologique par adjonction de composants syntactiques supplémentaires, les principes de la théorie de la réalité, qui laissent le caractère général de la syntaxe invariant. Plus précisément, pour élaborer une théorie de la réalité qui ait la propriété de vérité au même sens que la logique la possède, mais permette l’évaluation logique des déclarations concernant l’espace, le temps et les lois, nous devons jouxter des principes d’extension qui donnent un sens à de telles déclarations tout en préservant la propriété de tautologie.

Selon la nature de la logique propositionnelle, la vérité est tautologiquement basée sur l’intégrité de la réalité cognitive et perceptuelle. La cognition et la perception comprennent la base primitive (auto-définitive) de la logique, et la logique comprend les règles de structure et d’inférence en vertu desquelles la perception et la cognition sont stables et cohérentes. Donc, lorsque nous disons que la vérité est héritable en vertu de règles logiques d’inférence, nous entendons en réalité que la tautologie est héritable et que la base cognitive-perceptuelle primitive de la logique propositionnelle conserve ainsi son statut principal. En convertissant les tautologies en d’autres tautologies, les règles d’inférence de la logique propositionnelle convertissent les invariants cognitifs-perceptuels en d’autres invariants. Pour poursuivre ce programme dans la théorie de la réalité, nous devons identifier des principes décrivant comment la structure en boucle de la tautologie logique est manifeste dans divers configurations et contextes réalité-théoriques à différents niveaux de description et d’interprétation; de cette façon, nous pouvons vérifier sa conservation dans les opérations de réduction et d’extension théoriques. C’est-à-dire que nous devons jouxter les principes généralisés de la structure bouclée à la syntaxe logique de manière à ce que de plus en plus de la réalité soit ainsi expliquée et que l’exhaustivité soit réalisée.

Par exemple, prenons la tautologie propositionnelle « X v ~ X » (X OU NON-X). Appliqué à la perception, cela signifie que lorsque quelque chose est vu ou observé, il n’est pas vu en conjonction avec son absence; si c’était le cas, alors deux perceptions contradictoires coïncideraient, aboutissant à un « éclatement » des réalités perceptuelles. En effet, soit la conscience de celui qui perçoit serait scindée en deux réalités cognitives distinctes dans un cas de dissociation en chaîne réactive, soit le spectateur lui-même se scinderait physiquement avec la réalité physique. Quand « X v ~ X » est composé avec d’autres tautologies (ou lui-même) par substitution, les enjeux sont exactement les mêmes; toute violation de la tautologie composée diviserait la réalité perceptuelle et cognitive avec des implications désastreuses pour son intégrité.28

Après sa nature tautologique, la première chose à noter à propos de la logique propositionnelle dans le contexte de la théorie de la réalité est que, contrairement à l’esprit dans lequel elle a été fondée – elle représente, après tout, les règles des processus mentaux29 de la cognition qui semble lui conférer un caractère mental dès le début – elle présente une insuffisance fonctionnelle fondamentale : elle semble nécessiter un logicien externe pour le lire, le comprendre et l’appliquer mentalement. D’autre part, la nature (ou la réalité cognitive-perceptuelle) ne nécessite aucun logicien externe pour appliquer les règles de la logique. Par conséquent, les principes tautologie-préservant proposés de la théorie de la réalité devraient replacer l’esprit dans le mélange de manière explicite et théoriquement traitable, en dotant la logique de « capacité de traitement automatique ». Après tout, c’est exactement ce qu’elle possède dans sa manifestation naturelle, la réalité au sens large, et une dimension essentielle de la propriété de fermeture sans laquelle la vérité est insoutenable. C’est-à-dire que la réalité doit pouvoir se reconnaître et conférer cette capacité à ses composants en tant que condition de leur existence et de leurs interactions.

Après avoir expliqué les principaux problèmes techniques de la théorie de la réalité, nous pouvons passer maintenant à la chasse : la façon de construire une théorie de la réalité consiste à identifier les propriétés qu’elle doit inconditionnellement posséder pour exister, mettre au point la théorie en la définissant comme possédant ces propriétés sans introduire simplement des propriétés contingentes qui, si elles étaient considérées comme générales, pourraient nuire à leur relation descriptive avec l’univers réel (celles-ci peuvent venir plus tard et seront naturellement sujettes à une confirmation empirique). En d’autres termes, les moyens utilisés pour construire la théorie doivent être rationnels et tautologiques, tandis que ceux permettant de l’affiner ultérieurement peuvent être empiriques. Puisque nous voulons que notre théorie soit suffisamment inclusive, suffisamment exclusive et suffisamment consistante pour faire le boulot de décrire la réalité, ces propriétés incluront certainement l’exhaustivité (moins complète mais aussi moins indécidable que la complétude), la fermeture et la consistance. À ces propriétés, les « 3 C » [NDT : Comprehensiveness, Closure, Consistency], nous allons assigner trois principes de forme essentiellement tautologique; De cette manière, les relier à la théorie de la réalité basée sur la logique préservera la propriété de tautologie de la logique, excluant rationnellement l’incertitude par les mêmes moyens que la logique elle-même. Une théorie de la réalité construite de cette manière est appelée supertautologie.

Parce que nos trois principes correspondent aux 3 C et qu’ils commencent tous par la lettre M, nous pourrions aussi bien les appeler les « 3 M » : M = R, MAP et MU, respectivement pour le Principe Mind Equals Reality, le Principe de l’Autologie Métaphysique et le Principe d’Unité Multiplexe. Le principe M = R, propriété théorique tautologique qui dissout la distinction entre théorie et univers et identifie ainsi l’univers réel comme une « théorie auto-réifiante », rend la syntaxe de cette théorie exhaustive en veillant à ce que rien qui puisse être cognitivement ou perceptiblement reconnu comme faisant partie de la réalité ne soit exclu faute de syntaxe. MAP rend tautologiquement cette syntaxe fermée ou autonome dans les sens définitif, descriptif et interprétatif et, conjointement avec M = R, rend l’univers parfaitement autonome dans l’affaire. Et MU rend tautologiquement cette syntaxe, et le complexe théorie-univers qu’elle décrit, suffisamment cohérente pour assurer sa propre consistance (ainsi, le « C » correspondant à MU se divise en fait en deux C, consistance et cohérence, nous en avons donc quatre en tout). Pour chacun de ces principes nous pouvons ajouter toutes corollaires utiles qui se présentent.30

Comme il est du domaine de tout théoricien de la réalité d’utiliser des propriétés de la réalité pour expliquer la réalité et que ces propriétés sont définies de manière récursive, nous ferons parfois référence implicitement ou explicitement à diverses propriétés dans les descriptions d’autres propriétés. Cela exclut une série habile de définitions cumulatives, ce qui n’est possible dans tous les cas qu’en prenant pour acquis le contenu et les moyens de la théorisation (on ne peut malheureusement rien prendre pour acquis dans la théorie de la réalité). Comme nous le verrons plus loin, la nature récursive de la CTMU est inévitable. Deuxièmement, le CTMU est développé « à l’envers » par rapport aux théories déductives habituelles de la science et des mathématiques, en éliminant d’abord les contraintes et en utilisant ensuite seulement les résultats pour déduire des faits à propos du contenu. La plupart des théories commencent par des axiomes, des hypothèses et des règles d’inférence, extraient des implications, testent logiquement ou empiriquement ces implications, puis ajoutent ou révisent les axiomes, les théorèmes ou les hypothèses. Le CTMU fait l’inverse, éliminant les suppositions et « reconstruisant la réalité » tout en ne rajoutant aucunes suppositions.

Les principes suivants sont présentés en trois étapes. La première étape inclut le Principe de Réalité, le Principe de Réductibilité Linguistique et le Principe de Syndifféonèse, qui peuvent être considérés comme préliminaires à MAP, M = R et MU respectivement (l’ordre de présentation peut différer légèrement de celui qui vient d’être donné). La deuxième étape comprend MAP, M = R et MU eux-mêmes, tandis que la troisième étape consiste en plusieurs principes auxiliaires pouvant être considérés comme leurs conséquences.

Le Principe de Réalité

La réalité, c’est-à-dire l’univers réel, contient tout et seulement ce qui est réel. Le concept de réalité est analytiquement autonome; s’il y avait quelque chose hors de la réalité qui était suffisamment réel pour affecter ou influencer la réalité, il serait à l’intérieur de la réalité, et cette contradiction invalide toute supposition d’une réalité externe (jusqu’à la pertinence d’observation ou théorique).31

Bien que cette caractérisation de la réalité incorpore une définition circulaire de la pertinence, la circularité est essentielle au concept de réalité et n’exclut pas une base perceptuelle (observationnelle, scientifique). En effet, nous pouvons affiner la définition de la réalité comme suit : « La réalité est l’agrégat perceptuel comprenant (1) toutes les observations scientifiques qui ont été et seront faîtes, et (2) l’entière infrastructure explicative abstraite et/ou cognitive de la perception » (où l’abstrait est une généralisation syntactique de la signification concrète d’idées, de concepts ou de structures cognitives distribuées sur des instances physiques qui s’y conforment en tant que contenu conforme à la syntaxe).

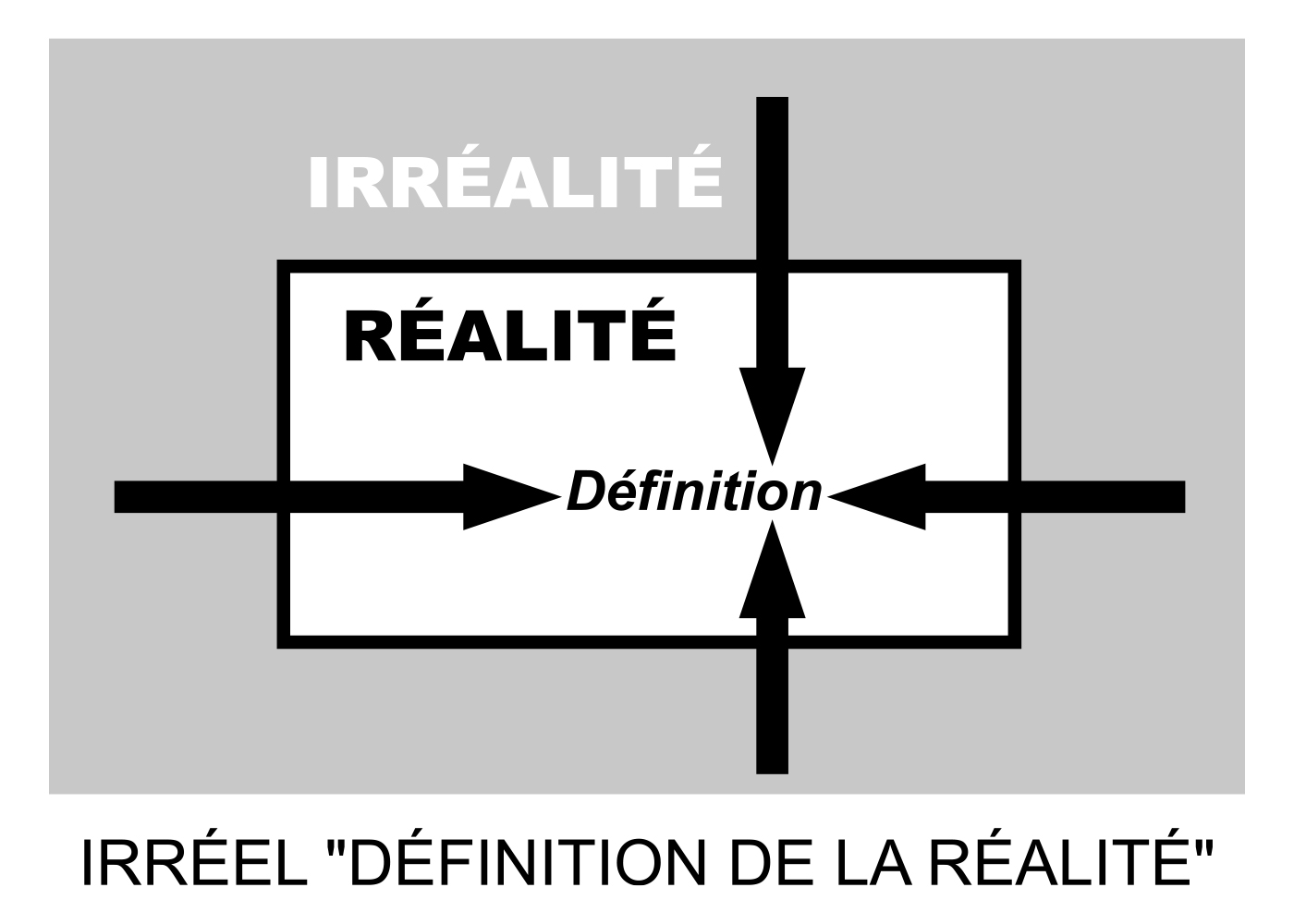

Diagramme 5

Il convient de noter que toute définition revient à une théorie microscopique de la chose définie. Le Principe de Réalité, qui peut être considéré comme une définition générale de la réalité, en est un exemple; cela peut être considéré comme le germe d’une théorie de la réalité que nous avons maintenant commencé à construire. En définissant la réalité comme autonome, cette « microthèorie » se dote d’une forme simple de fermeture ; elle ne fait appel à rien en dehors du definiendum au cours de sa définition, et interdit effectivement à toute extension future de cette définition de le faire (ceci devient explicite dans un principe connexe, le MAP).

Mais revenons maintenant à la liste. Jusqu’ici, nous avons appris que la réalité est autonome; elle est partout la même chose qu’elle-même. Qu’en est-il de toutes ses distinctions internes ?

La Syndifféonèse

La réalité est une relation, et chaque relation est une relation syndifféonique présentant une syndifféonèse ou « différence dans la similitude ». La réalité est donc une relation syndifféonique. La syndifféonèse implique que toute affirmation selon laquelle deux choses sont différentes implique qu’elles sont par réduction les mêmes; si leur différence est réelle, elles se réduisent toutes les deux à une réalité commune et sont dans cette mesure similaires. La syndifféonèse, le plus général des principes réducteurs, forme la base d’une nouvelle vision de la structure relationnelle de la réalité.

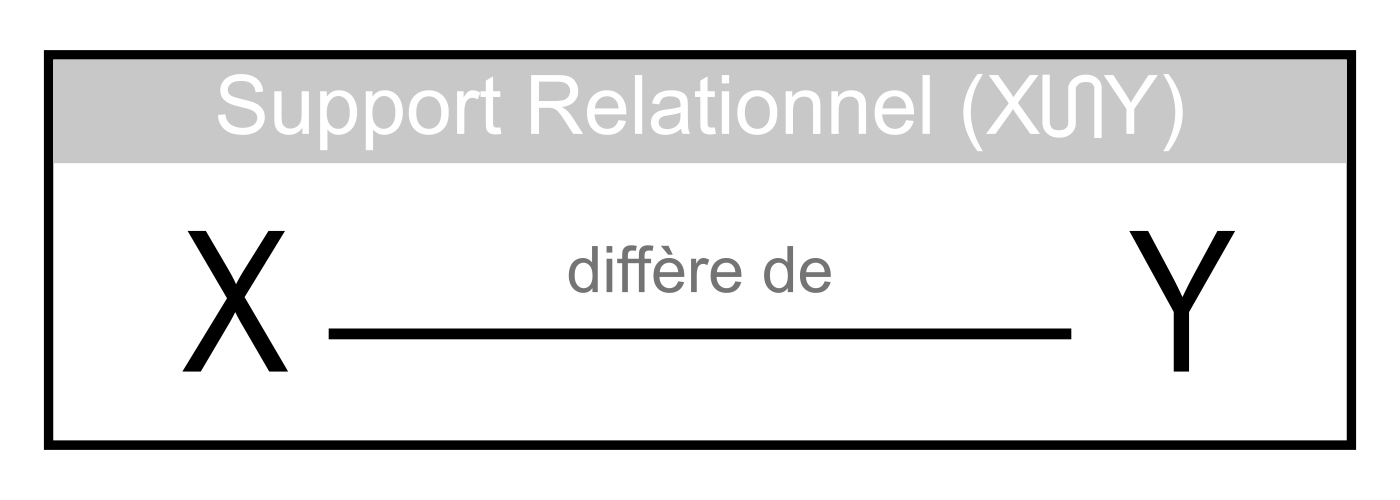

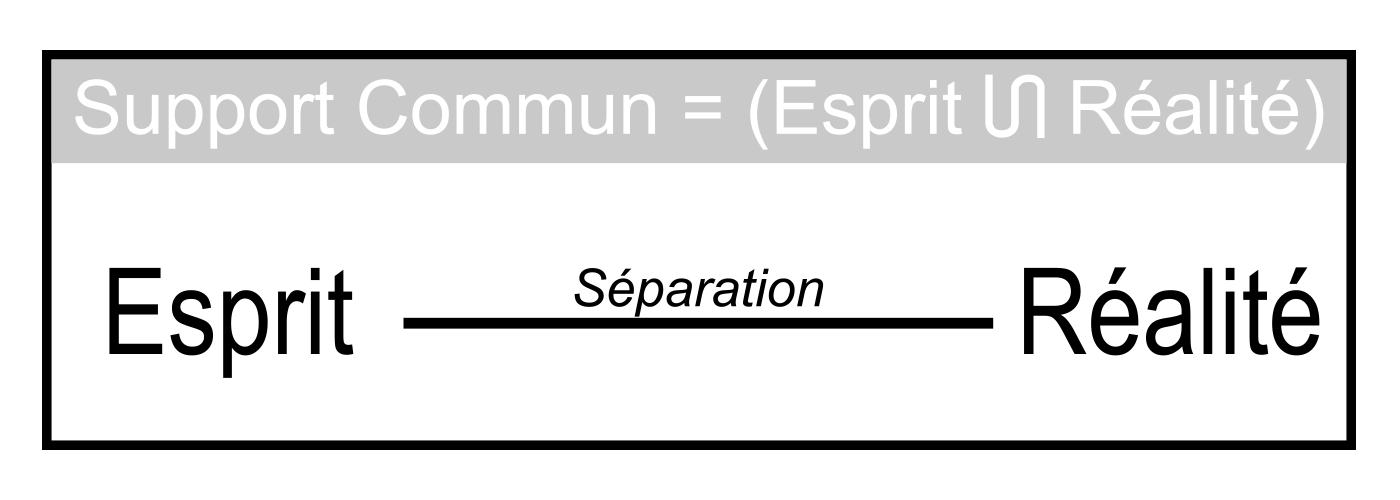

Le concept de syndifféonèse peut être saisit en affirmant que l’expression et/ou l’existence de toute relation de différence comprend un support et une syntaxe communs, c’est-à-dire les règles d’état et de transformation caractérisant le support. C’est de ces règles que la relation tire ses caractéristiques spatiales et temporelles telles qu’exprimées à l’intérieur du support. Ainsi, une relation syndifféonique consiste en une relation de différence intégrée dans un support relationnel dont les règles distribuées de structure et d’évolution soutiennent son existence.

Chaque relation syndifféonique a des phases synétiques et difféoniques présentant respectivement une synèse et une difféonèse (similitude et différence, ou distributivité et localité paramétrique), et présente deux formes de confinement, topologique et descriptif. Le support est associé à la phase synétique, tandis que la relation de différence est associée à la phase difféonique (les règles d’état et la transformation du support y étant distribuées, le support est homogène, ne possédant intrinsèquement qu’une extension relative du fait des relations de différence qu’il contient). Les retours difféoniques étant liés à leur support d’expression commun et à sa syntaxe distributive de manière à combiner les aspects d’union et d’intersection, l’opération produisant le support à partir des retours s’appelle unisection (U). Le support synétique représente le potentiel difféonique dont la relation de différence est une actualisation.

Diagramme 6 : Ce diagramme syndifféonique générique illustre un fait simple : toute relation de différence nécessite un support avec extension dans le paramètre différentiel. Comme illustré, le support distribue à la fois la relation linéaire « X diffère de Y » et de ses retours (entités liées) X et Y, leur conférant une propriété « de parenté » commune équivalant à « l’inclusion dans le support relationnel XUY », où XUY est le produit unisecte ou « produit syntactique » de X et Y. Cet attribut commun invalide toute affirmation selon laquelle la différence entre les retours est « absolue » ou « irréductible »; le simple fait que la différence puisse être exprimée linguistiquement ou géométriquement implique qu’elle n’est que partielle et que les deux retours sont des manifestations d’un seul et même support ontologique. Lorsque X et Y représentent des parties ou des aspects arbitraires de la relation de différence appelée réalité, ce diagramme montre graphiquement que la réalité consiste finalement en un support ontologique unitaire. En conséquence, la théorie de la réalité doit être une théorie monique réduisant la réalité à ce support (cette idée est développée plus avant dans le Principe du Monisme Infocognitif).

Notez que toute inhomogénéité syntactique (par opposition à informationnelle) dans le support commun est en soi une relation de différence et invite donc à une reconstitution du diagramme. De même, toute inhomogénéité dans le support commun illustrée par le diagramme recréé inviterait une autre reproduction du diagramme, etc. Toute régression syndifféonique de ce type doit prendre fin, car sinon, il n’y aurait pas de syntaxe stable et donc pas de « relation » suffisamment stable pour être perçue ou conçue. La stabilité informationnelle de la réalité perceptuelle montre que la syntaxe de la réalité est stable.

Le diagramme ci-dessus pourrait être exprimé de manière compacte comme suit: syn(XUY):diff(X, Y). Par exemple, syn(nomAX U nomBX):diff(nomAX, nomBX) signifie que lorsque nomAX, nomBX sont des ensembles de lois auxquelles le système X obéit à différents moments, emplacements ou cadres de référence A et B dans le système X, il existe un ensemble plus fondamental de lois (nomAX U nomBX) en fonction duquel cette différence peut être exprimée. Cela montre qu’à un certain niveau, la covariance générale doit tenir. Ce n’est pas simplement vrai « jusqu’à l’isomorphisme avec X »; même si plusieurs ensembles de lois valides peuvent être distingués, l’un d’entre eux pouvant être actif à un endroit donné (A, B,…) dans X [XA ⊨nom1, XB ⊨nom2, …, où les indices numériques désignent la distinction nomologique], toute différence distinguable entre ces ensembles nécessite également une syntaxe commune. La cohérence informationnelle est donc une condition sine qua non d’une existence reconnaissable; tout système dans lequel elle échouerait se décohérerait simplement faute de quoi tenir.

En d’autres termes, (1) lorsque des distinctions d’information concernant un système X sont considérées comme des instanciations de loi, elles peuvent également être considérées comme des expressions conformes à la syntaxe; et (2) l’expression des différences nécessite une syntaxe d’expression unifiée (ou ensemble de « lois »), et cette syntaxe doit être distribuée sur l’ensemble des expressions différentielles (ou « instanciations de loi »). Par exemple, lorsque X est une « intersection perceptuelle » constituée d’objets, d’attributs et d’événements généralement reconnaissables, les lois de la perception doivent en définitive être constantes et distribuées. Lorsqu’il existe une différence nomologique présumée pour une paire de loci (A, B), la covariance syntaxique réductive s’applique en raison de la nécessité d’un support d’expression et, lorsqu’il n’existe de telle différence pour n’importe quelle paire de loci (A, B), la covariance syntactique s’applique a fortiori sans besoin de réduction.

Les relations syndifféoniques peuvent être considérées comme des éléments de réseaux infocognitifs plus complexes ayant des dimensions spatiales et temporelles (ordinales, stratificatives). Interprétés selon les principes de dualité du CTMU, les réseaux infocognitifs comprennent des relations logiques d’état et de syntaxe. La régression d’un de ces réseaux par unisection conduit finalement à un support syntaxique d’une généralité et d’une homogénéité parfaite… un « opérateur syntactique » universel et réflexif.

En effet, la syndifféonèse est en effet une tautologie métalogique équivalant à un paradoxe d’auto-résolution. Le paradoxe réside dans la coïncidence de la similitude et de la différence, tandis qu’une résolution de type théorique est inhérente à la distinction logique et mathématique qui les sépare, c’est-à-dire à la dimension stratificative d’un réseau infocognitif.32 Ainsi, réduire la réalité à une syndifféonèse revient à la « paradoxiformer ». Cela a un avantage : une théorie et/ou une réalité construite d’un paradoxe auto-résolvant est immunisée contre le paradoxe.